O cinema não passa de ilusão, literalmente — e o mesmo vale para suas contrapartes modernas. Afinal, cada filme que você já assistiu, cada vídeo que já visualizou no celular é resultado de um velho truque, conhecido desde o século 19: a reprodução de imagens sequenciais estáticas em velocidade constante, que engana seu cérebro e o faz entender aquilo como movimento.

Ao longo do tempo, muitos dos avanços na área têm buscado aperfeiçoar a ilusão e torná-la mais realista, convincente, imersiva — mesmo quando o que se exibe nas telas é a mais pura fantasia. De Georges Méliès, autor do clássico e influente curta-metragem Viagem à Lua (1902), à equipe da Industrial Light & Magic, responsável por, entre outros, um tal de Guerra nas Estrelas (1977), profissionais visionários vêm se dedicando a concretizar cenas outrora possíveis apenas na imaginação.

A geração de imagens por meio de computação gráfica foi uma das maiores revoluções no audiovisual nos últimos tempos. Era de se esperar, portanto, que o próximo grande marco se originasse, igualmente, de uma inovação tecnológica. A inteligência artificial parece destinada a cumprir esse papel; a diferença é que, nesse caso, a arte não só imita a vida como pode afetá-la de maneira dramática. E não há exemplo mais claro que o deepfake.

Antes de mergulhar no assunto, porém, vale a pena tentar entender ao menos os rudimentos técnicos.

As pesquisas em inteligência artificial englobam um campo chamado aprendizado de máquina (machine learning). Grosso modo, é um método em que o computador analisa uma porção de dados, identifica padrões e, a partir daí, consegue aprender por si, sem a necessidade de programação.

Outro campo relacionado e similar é o aprendizado profundo (deep learning), que explora múltiplas camadas de redes neurais artificiais — basicamente, algoritmos inspirados nos sistemas biológicos (como o nosso cérebro) e seus complexos mecanismos de processamento de informações. O objetivo é, mais uma vez, fazer com que a máquina consiga imitar aspectos da inteligência humana.

Em uma explicação simplificada, o deepfake é uma aplicação do aprendizado profundo, na qual geralmente se usa um tipo de rede neural artificial conhecido como autoencoder. Por exemplo, para colocar o rosto de Nicolas Cage em um vídeo qualquer, são necessários dois autoencoders: um alimentado com fotos do rosto do ator e outro com fotos de diferentes pessoas.

Wow! Nic Cage vira O Escolhido em vídeo carregado no YouTube pelo usuário derpfakes

Wow! Nic Cage vira O Escolhido em vídeo carregado no YouTube pelo usuário derpfakesUsando reconhecimento facial, cada autoencoder analisa, então, a maneira como esses rostos se comportam naturalmente em diversos ângulos e condições de iluminação. Uma vez que eles tenham sido treinados — ou seja, tenham aprendido os mínimos detalhes acerca de seus objetos de estudo —, é possível combinar os dados resultantes para fazer com que Cage interprete Thanos, Vito Corleone, Neo e outros personagens.

Como se pode supor, essa tecnologia vem sendo desenvolvida já há algumas décadas. No entanto, foi só nos últimos anos que ela ganhou exposição, impulso e seu nome popular.

Em dezembro de 2017, uma reportagem da Vice revelou que um usuário do Reddit estava publicando vídeos pornográficos alterados por meio de aprendizado profundo, nos quais os rostos das atrizes eram substituídos pelos de celebridades, como Gal Gadot, Scarlett Johansson e Taylor Swift.

O texto admitia que, apesar de longe da perfeição, o trabalho “em um relance” parecia “crível”. E observava que mais notável era a facilidade com que fora criado (e as implicações disso): de forma amadora, usando um computador comum e ferramentas gratuitas. O username do autor do material: deepfakes.

O nome daquele redditor acabou associado ao formato, que, desde então, só fez crescer. Inicialmente, ficou restrito a audiências adultas — o que, inclusive, levou plataformas a banir esse tipo de vídeo por configurar conteúdo não consensual. Logo, porém, se expandiu para o público geral, por meio de usos mais inofensivos, como aplicativos de celular e produções bem-humoradas, que podem ressaltar o talento de Bill Hader como imitador, imaginar Keanu Reeves impedindo um assalto ou apenas causar enorme estranheza no espectador.

Mesmo assim, quando se fala de deepfake, a pauta principal continua sendo o potencial nocivo de algumas de suas aplicações. Infelizmente, as estrelas não são os únicos alvos; um grande número de mulheres que não estampam capas de revistas tem sido vítima de vídeos falsos, feitos com o único intuito de expô-las, agredi-las.

E obviamente, há a possibilidade de a tecnologia ser empregada com fins políticos, o que poderia ter resultados catastróficos. Ainda não se registrou um caso contundente, mas a ameaça está aí. Tanto que, a fim de chamar atenção para o assunto, o BuzzFeed produziu um agora famoso exemplo com o ex-presidente norte-americano Barack Obama sendo dublado pelo ator e diretor Jordan Peele.

Sigam-me os bois! "Chapolin Bolsonaro" foi o primeiro vídeo de Sartori a viralizar

Sigam-me os bois! "Chapolin Bolsonaro" foi o primeiro vídeo de Sartori a viralizarFoi justamente isso que passou a preocupar Bruno Sartori depois que um vídeo feito por ele, com o rosto do presidente Jair Bolsonaro encaixado no corpo do Chapolin Colorado, ganhou projeção nacional. “Percebi que as pessoas precisavam ter mais contato com a tecnologia, antes que ela fosse usada para [cometer] um crime que pudesse mudar os rumos da democracia”, diz.

Ele acrescenta que uma população pouco familiarizada com o deepfake estaria vulnerável, passível de ser facilmente enganada por uma falsificação envolvendo, por exemplo, um candidato às vésperas da eleição. Assim, decidiu agir antes que “um dano maior viesse a acontecer”. De quebra, aproveitou para continuar fazendo críticas ácidas ao atual governo.

O que era para ser apenas um experimento isolado, portanto, virou rotina. Bruno tem publicado regularmente novos vídeos na mesma linha — a exemplo das hilárias paródias de Papai, Eu Quero me Casar e Florentina, entre outros — em suas redes sociais e seu canal no YouTube, sempre com centenas de milhares de visualizações e outro tanto de curtidas e compartilhamentos. Não à toa, ele se tornou o principal nome relacionado ao deepfake no Brasil.

A experiência com edição de vídeo vem desde a época em que o jornalista mineiro fazia sátiras envolvendo políticos da cidade em que morava, Unaí (MG). Ao esbarrar nas primeiras discussões sobre a nova tecnologia em fóruns online, vislumbrou suas possibilidades e foi se aprofundar, caçando referências, trocando informações com outros usuários e aprendendo na prática. Precisou de seis meses de dedicação até obter os primeiros resultados que julgou aceitáveis.

Hoje, cada vídeo leva, em média, de três a sete dias para ficar pronto, embora alguns exijam até duas semanas de trabalho. “Depende da complexidade: se ainda preciso treinar determinado rosto, se tem muitos ângulos para copiar, se preciso ‘relabializar’ as palavras [modificar o movimento dos lábios para se encaixar em uma fala] ou se só vou inserir um rosto em outro”, enumera ele, que cuida de todo esse processo sozinho, contando com colaboradores apenas na parte de interpretação das vozes.

O jornalista Bruno Sartori: de 3 a 7 dias para produzir seus deepfakes satíricos

O jornalista Bruno Sartori: de 3 a 7 dias para produzir seus deepfakes satíricosNão é surpresa que o trabalho de Bruno atraia ódio. Ele já recebeu ameaças de morte e teve dados pessoais expostos. “A gente não pode se deixar intimidar por esses covardes. Todos foram identificados e estão respondendo a processo”, diz o jornalista, que tem também formação ainda não concluída em Direito. Com tais medidas tomadas, diminuíram os ataques sérios, restando apenas as ofensas, recebidas com o merecido desdém. Afinal, a sátira, que data da Antiguidade Clássica, tem respaldo da lei.

De acordo com o advogado Marcelo Marineli, mestre e doutor em Direito Civil pela PUC-SP e professor do Mackenzie:

“O Supremo Tribunal Federal já se manifestou nesse sentido em decisão proferida em 2018. Para a Corte, a liberdade de expressão deve ser garantida, abarcando inclusive manifestações de caráter humorístico e satírico, ainda que mediante a utilização de trucagem, montagem ou outros recursos de áudio e vídeo.”

Se por um lado a liberdade de expressão é ponto pacífico, por outro, o deepfake é objeto de crescente estudo e preocupação por parte da comunidade jurídica. Para entender que instrumentos existem para coibir e punir condutas criminosas que se utilizem dessa tecnologia, é preciso dedicar algumas linhas às questões legais.

Nossa vida cotidiana é regulamentada por normas, descritas nos Códigos Civil, Penal, Tributário, Eleitoral e na Constituição Federal, entre outros. E desde 2014, nossa vida online dispõe de uma lei própria, chamada Marco Civil da Internet. “Estabelece direitos, deveres e princípios para a utilização e o desenvolvimento da internet no Brasil. Sua importância está no pioneirismo de ter inaugurado uma norma dedicada ao assunto. Ou seja, colocou um pouco de ordem no que, até então, era um ‘território sem lei’ e de pouca compreensão técnica”, explica Marcelo.

Embora seja mais citado em discussões sobre proteção de dados e neutralidade da rede, o Marco Civil da Internet abrange outros pontos importantes, ajudando, inclusive, a evitar decisões judiciais hoje inimagináveis.

Em 2007, a apresentadora Daniella Cicarelli e o então namorado foram filmados em momento íntimo por um paparazzo, e o vídeo foi colocado no YouTube. “Ao tentar retirar esse conteúdo da rede e se deparar com barreiras de ordem técnica, o Judiciário paulista simplesmente derrubou a plataforma no país. Após a entrada em vigor do MCI, não vimos mais esse tipo de situação ocorrer”, lembra o advogado, cujo mestrado foi sobre privacidade e redes sociais.

Diante de crimes como os mencionados anteriormente, a lei do mundo online pode dialogar com as outras. Se uma pessoa descobrisse que um deepfake pornográfico com seu rosto foi colocado no ar, ela poderia se valer do Marco Civil da Internet para solicitar a remoção daquele material e o fornecimento dos dados de acesso, a fim de identificar o autor. Uma vez que isso acontecesse, o responsável poderia responder nas esferas civil (tendo de indenizar a vítima) e penal. Segundo Marcelo:

“Em 2018, o Código Penal passou a punir a montagem de cena de nudez ou ato sexual envolvendo maiores de idade (artigo 216-B, Parágrafo Único), com pena de detenção, de 6 meses a 1 ano, e multa. Ainda que não mencione especificamente a tecnologia envolvida na criação do conteúdo, a referida norma abarca o deepfake.”

Deepfake de Hillary Clinton a partir de esquete do Saturday Night Live: uso eleitoral gera preocupação

Deepfake de Hillary Clinton a partir de esquete do Saturday Night Live: uso eleitoral gera preocupaçãoResultado similar teria um vídeo falso produzido com objetivo de prejudicar um candidato. O MCI garantiria os meios para sua retirada e a identificação do autor, que então poderia ser enquadrado em crimes previstos no Código Eleitoral: divulgar, na propaganda, fatos que sabe inverídicos em relação a partidos ou candidatos e capazes de exercer influência perante o eleitorado (artigo 323); ou denunciação caluniosa com finalidade eleitoral (artigo 326-A).

A questão é que, em ambos os exemplos, o que temos é reparação e punição depois que o estrago já foi feito. Como impedir que ele ocorra?

“Planos de contenção de disseminação de material manipulado por usuários, implementados pelas próprias redes sociais, são fundamentais”, considera o advogado. Ele lembra que tramita no Senado o projeto da chamada “Lei das Fake News” (PL nº 2.630/2020). “Traz a previsão de que aos provedores de conteúdo cabe a tomada de medidas necessárias para proteger a sociedade contra a difusão de desinformação por meio de seus serviços”, observa.

Outro problema é o ritmo em que a tecnologia avança. Hoje, o deepfake pode ser identificado por meio da análise de detalhes no rosto (como sobrancelhas e pele), no áudio e na iluminação; mas não tarda o dia em que ele conseguirá enganar até mesmo os peritos. Recentemente, o Facebook, em parceria com a Universidade do Michigan, anunciou uma ferramenta para detectar esse tipo de vídeo. É um passo no rumo certo, porém as pesquisas nesse sentido ainda recebem pouca atenção e recursos, o que faz com que especialistas da área se sintam em temerosa desvantagem.

O que não significa, de maneira alguma, que o desenvolvimento de tais aplicações da inteligência artificial deva ser freado. Técnicas similares às que viabilizam o deepfake podem trazer grandes contribuições em diversas áreas, de Medicina a Educação — só depende da criatividade e empenho dos pesquisadores.

Por exemplo, um dos projetos nos quais Bruno Sartori está trabalhando, em parceria com uma empresa estrangeira, envolve comunicação em vídeo entre falantes de línguas diferentes. “Você será capaz de conversar no seu idioma, enquanto, do outro lado, a pessoa vai vê-lo, em tempo real, falando e mexendo os lábios no idioma dela”, antecipa o jornalista.

Ele acrescenta que já há um protótipo funcional, que, por enquanto, utiliza uma voz padrão, pré-gravada, para articular as palavras. Mas ele afirma que, logo, conseguirá alterar também o áudio, copiando o timbre de voz dos usuários e convertendo-o para outra língua.

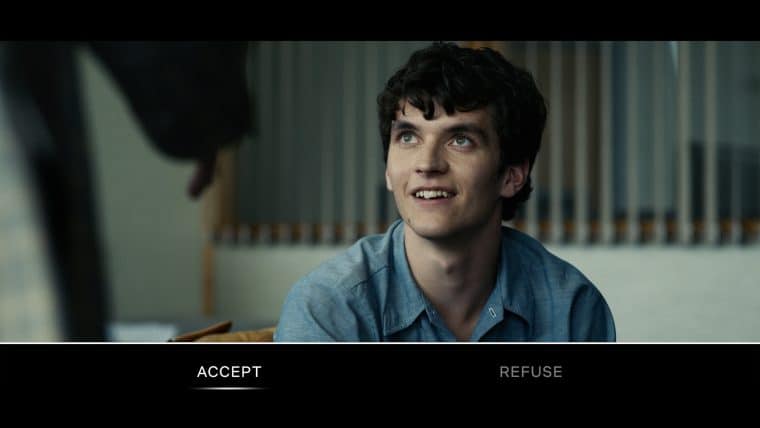

Nova tecnologia pode superar interatividade de Black Mirror: Bandersnatch (2018) [Netflix]

Nova tecnologia pode superar interatividade de Black Mirror: Bandersnatch (2018) [Netflix]Sem falar no potencial para a indústria cultural. Bruno aposta que o deepfake tem tudo para transformar a dublagem de conteúdo. E prevê que, muito em breve, será possível inserir o espectador em uma série ou filme, encaixando seu rosto no protagonista — para isso, bastará enviar algumas fotos. “Não é uma coisa cara nem difícil de fazer. Imagine um episódio de Black Mirror escrito especificamente para ter o público dentro da história”, sugere.

Seria um ponto alto em experiência imersiva. No fundo, é o que muitos dos avanços na área têm buscado. Nesse sentido, o deepfake não passa de mais uma ferramenta à disposição dos criadores. Pode ser usado para entreter, para provocar reflexão ou para manipular.

O próprio cinema, ainda em seus primórdios, já serviu como veículo para ideologias nefastas — vide o supremacismo branco em O Nascimento de Uma Nação (1915), de D. W. Griffith. Ao longo do tempo, a Sétima Arte nunca deixou de ser explorada dessa forma. Às vezes, isso era feito abertamente, a exemplo da propaganda nazista em Triunfo da Vontade (1935), de Leni Riefenstahl. Em outras ocasiões, a influência era mais sorrateira, como os sentimentos antissoviético e anti-islâmico promovidos por Hollywood durante, respectivamente, a Guerra Fria e o início dos anos 2000.

O mesmo vale para suas contrapartes modernas. Não são raros os canais no YouTube e em outras redes que hoje despejam teorias conspiratórias e/ou revisionismo histórico, alardeados como “verdade” paralela.

Se uma ferramenta tem grande potencial de dano, cabe à sociedade ficar de olho.

Legisladores e autoridades têm a obrigação de se manterem alertas em relação ao deepfake. As grandes plataformas devem assumir sua responsabilidade e desempenhar papel ativo no combate à propagação de mentiras, derrubando conteúdo falso com a mesma agilidade com que removem material que infringe direitos autorais. Aos pesquisadores, urge encontrar meios de nos tornarmos tão bons em reconhecer vídeos falsos como somos em criá-los. E o público precisa de informação, sempre a melhor arma contra qualquer coisa fake, seja imagem, som ou notícia.

Simplesmente demonizar a tecnologia e esperar que as ameaças desapareçam por si é a pior das ilusões.

)

)

)

)

)

)

)

)

)

)

)